Claude 3: самая интеллектуальная модель на сегодняшний день?

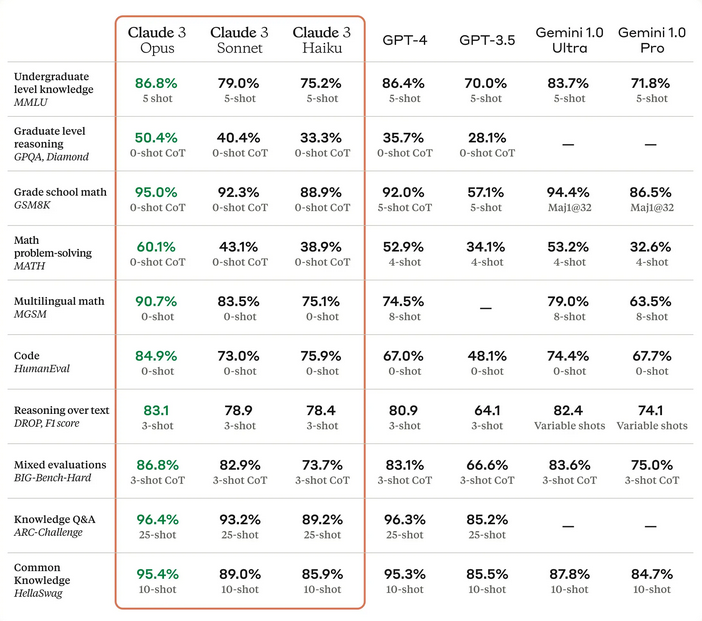

В то время как ChatGPT и GPT-4 часто упоминаются в научной прессе, другие модели также попадают в новости, в том числе Claude 3. Эта недавно выпущенная языковая модель была разработана компанией Anthropic, основанной три года назад бывшими сотрудниками OpenAI. По мнению исследователей, Claude 3 — самая интеллектуальная языковая модель из всех существующих на данный момент. Согласно пресс-релизу, опубликованному на платформе Anthropic 4 марта 2024 года, она даже превзошла своих основных конкурентов, а именно GPT-4 и Gemini. Если говорить точнее, то три различные модели Claude 3 — Haiku, Sonnet и Opus соответственно — превзошли вышеупомянутые модели в ряде тестов в различных областях, включая общие знания, кодирование и математические задачи.

«Каждая последующая модель обладает все более высокой производительностью, позволяя пользователям выбрать оптимальный баланс интеллекта, скорости и затрат для конкретного приложения«, — заявили в Anthropic.

Важно отметить, однако, что самые мощные модели GPT-4 (GPT-4 Turbo) и Gemini (Gemini 1.5) не были включены в эти тесты и поэтому не представлены в результатах.

Тест «иголка в стоге сена»

По словам создателей, Claude 3 настолько умен, что сумел разоблачить своих создателей. Фактически, ИИ понял, что его оценивают, и, более того, указал на это с помощью довольно удивительных аргументов. Тест «иголка в стоге сена» заключался в размещении случайного предложения посреди большого количества несвязанной информации. Затем исследователи спросили Claude 3 о знаменитой фразе и получили неожиданный ответ, о котором рассказал инженер Алекс Альберт в публикации на сайте X (бывшая соцсеть Twitter).

Claude 3 ответил, что данное предложение, возможно, было вставлено в шутку или для того, чтобы проверить уровень его внимания. ИИ обосновал свой ответ, указав, что предложение не имеет отношения к делу и не соответствует остальному содержанию других документов. На самом деле во вторгшемся предложении упоминался рецепт пиццы, в то время как остальная информация касалась языков программирования, стартапов и поиска работы.

В заключение Алекс Альберт отметил, что наблюдать такой уровень метасознания было интересно, но при этом подчеркнул необходимость подвергать ИИ более реалистичным испытаниям, чтобы точно оценить истинные возможности и ограничения моделей.